第一次部署开源ChatGLM-6B纪实

前言:部署过程超级简单 !!!!

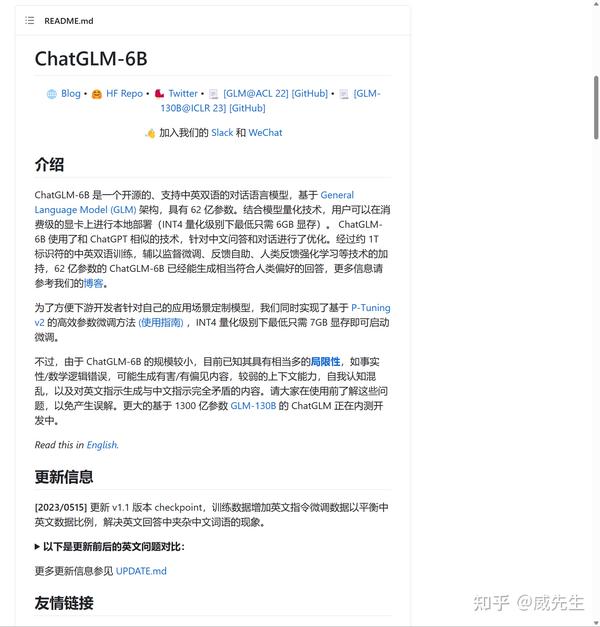

进入github THUDM/ChatGLM-6B: ChatGLM-6B: An Open Bilingual Dialogue Language Model | 开源双语对话语言模型 (github.com)

下拉至READEME.md,查看文档。

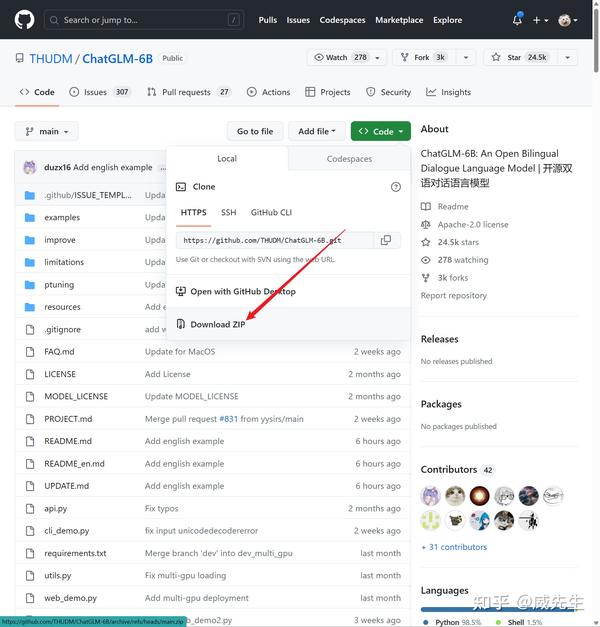

可以选用git bash 本地运行 git clone THUDM/chatglm-6b · Hugging Face

也可使用一键打包下载

遇到报错:没有cuda

1 | AttributeError: C:\\Program Files (x86)\\NVIDIA Corporation\\PhysX\\Common\\cudart64\_30\_9.dll: undefined symbol: cudaDeviceGetAttribute |

解决方法:

调用的dll中发生错误 · Issue #23 · THUDM/ChatGLM-6B (github.com)

(17条消息) 【Windows11】Cuda和Cudnn详细安装教程_Jin·的博客-CSDN博客

解决完毕,刷新后运行:

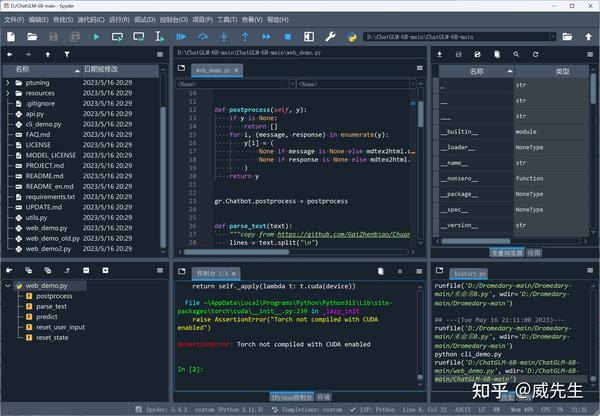

再次遇到报错:Torch无法启用cuda进行编译

AssertionError: Torch not compiled with CUDA enabled

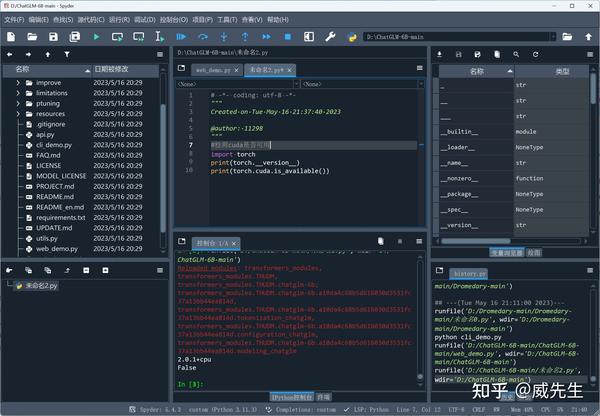

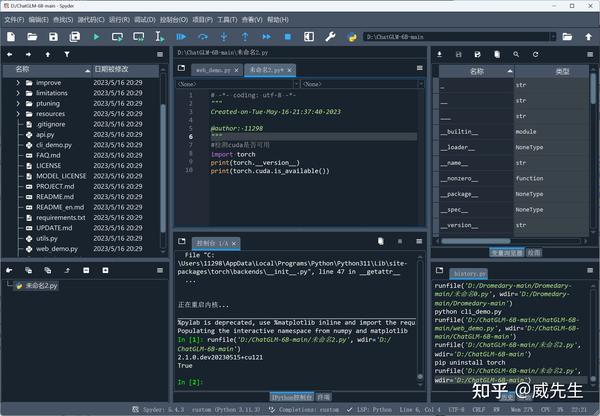

怀疑是cuda和torch版本可能不匹配,测试一下

1 | #检测cuda是否可用 |

出现以下情况:

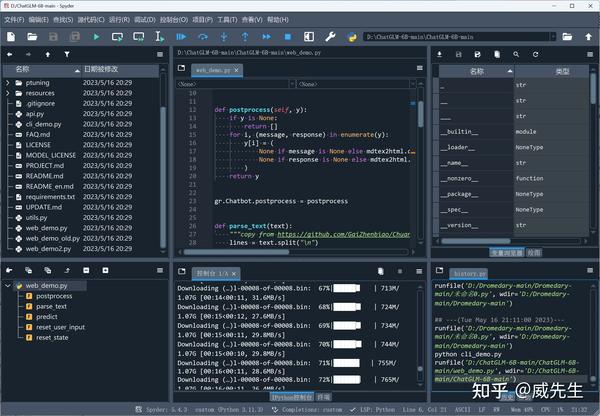

1 | Reloaded modules: transformers_modules, transformers_modules.THUDM, transformers_modules.THUDM.chatglm-6b, transformers_modules.THUDM.chatglm-6b.a10da4c68b5d616030d3531fc37a13bb44ea814d, transformers_modules.THUDM.chatglm-6b.a10da4c68b5d616030d3531fc37a13bb44ea814d.tokenization_chatglm, transformers_modules.THUDM.chatglm-6b.a10da4c68b5d616030d3531fc37a13bb44ea814d.configuration_chatglm, transformers_modules.THUDM.chatglm-6b.a10da4c68b5d616030d3531fc37a13bb44ea814d.modeling_chatglm |

版本是2.0.1,出现False,说明二者不兼容——torch是cpu的版本。

安装cuda版本Pytorch:

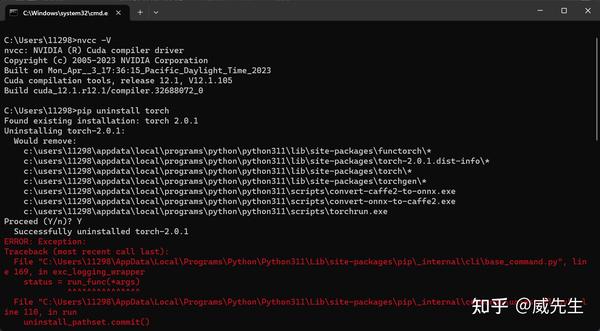

卸载不合适的Pytorch

1 | pip uninstall torch |

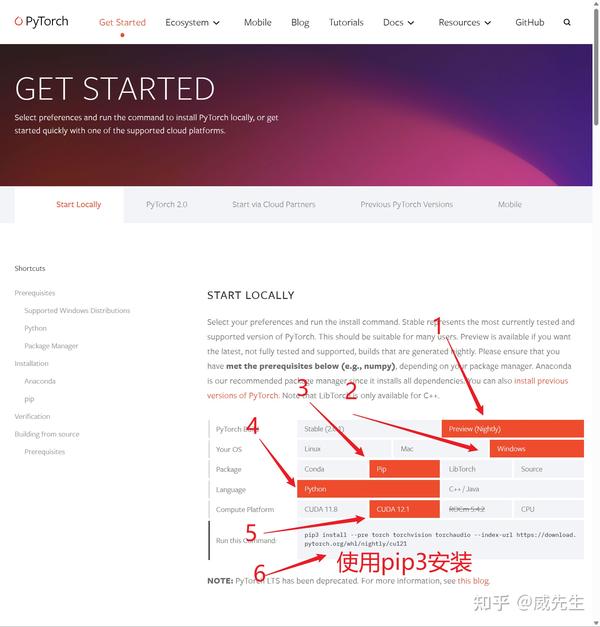

版本对应顺序:Python版本 -> Pytorch版本 -> Cuda版本

查看python版本 我的是 3.11.3

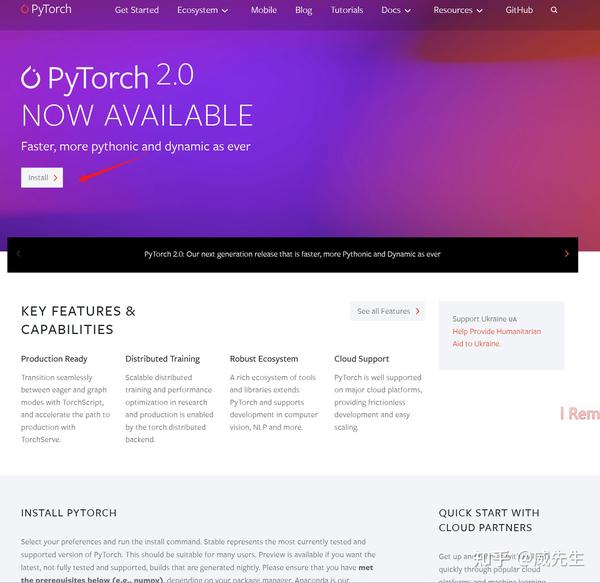

下载对应python版本的Pytorch 网址: PyTorch

选择适合自己硬件的torch版本,我装了最新的cuda 12.1

复制pip3代码

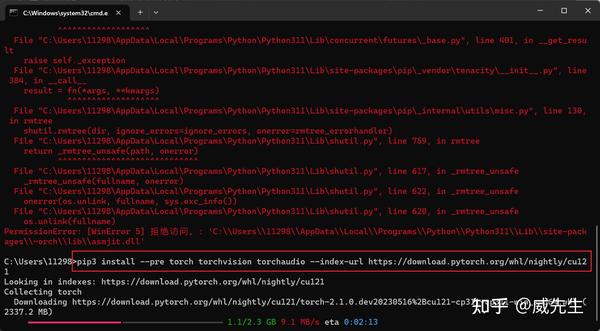

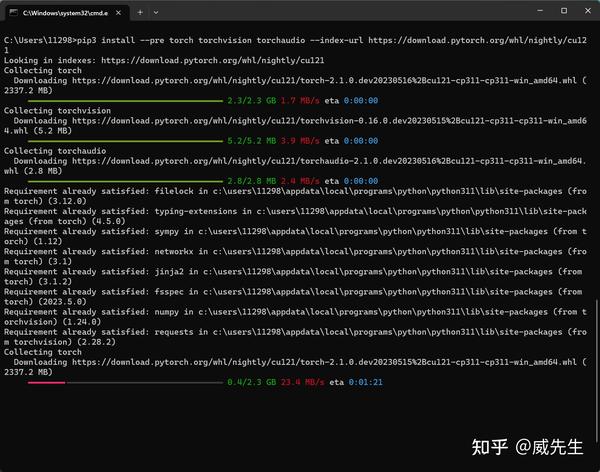

1 | pip3 install --pre torch torchvision torchaudio --index-url https://download.pytorch.org/whl/nightly/cu121 |

win+r -> cmd 运行

以前将 python 装在 c 盘,直接给我来了个 c 盘刺客

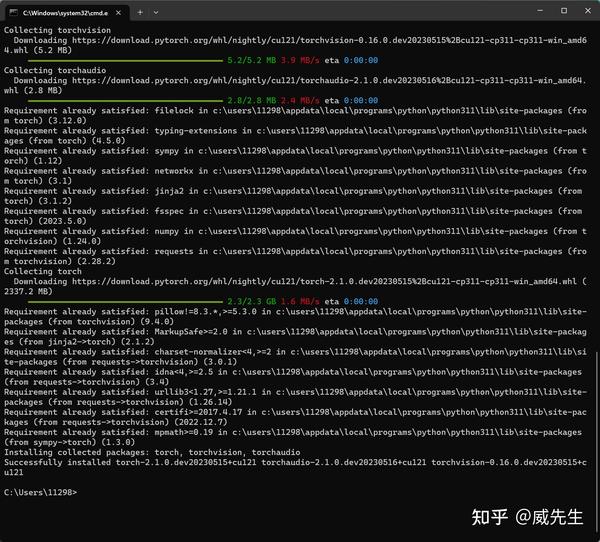

1 | #安装完成 |

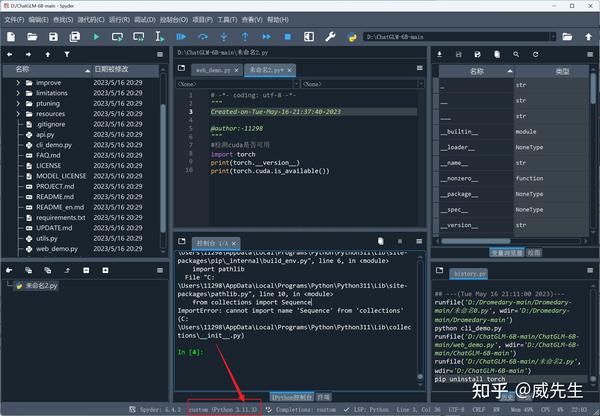

在spyder中重启内核后运行检测torch是否有效的代码

显示True !!! ,可以愉快的玩耍了!!!

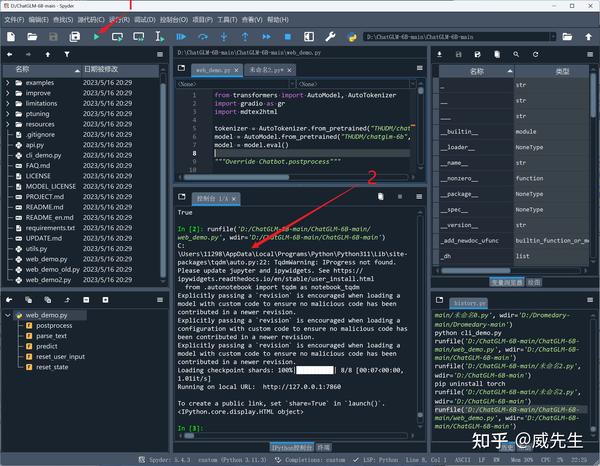

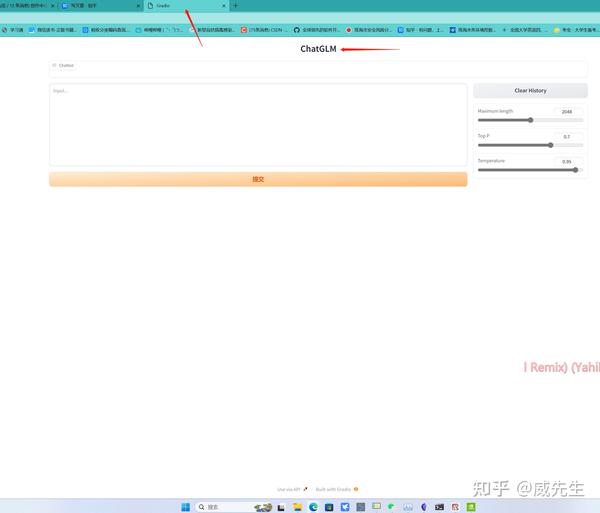

运行一下 ChatGLM-6B-main 内的 web_demo.py #这是通过网页调用

运行完毕后自动跳出网页

可以看出运行在本地 127.0.0.1:7860 上

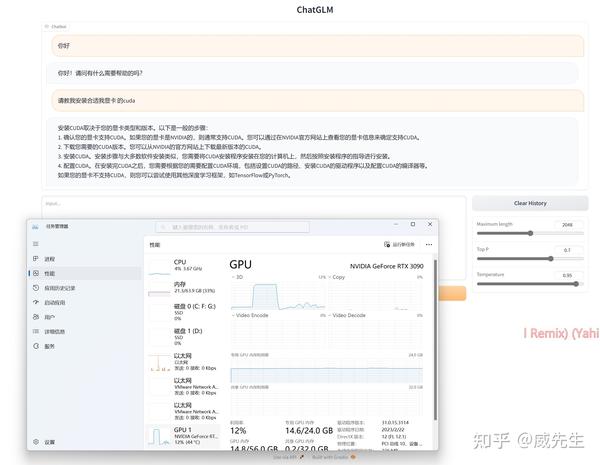

尝试向它问个好,再看看gpu占用

补充

cuda不兼容的情况——解决方法:安装合适的cuda

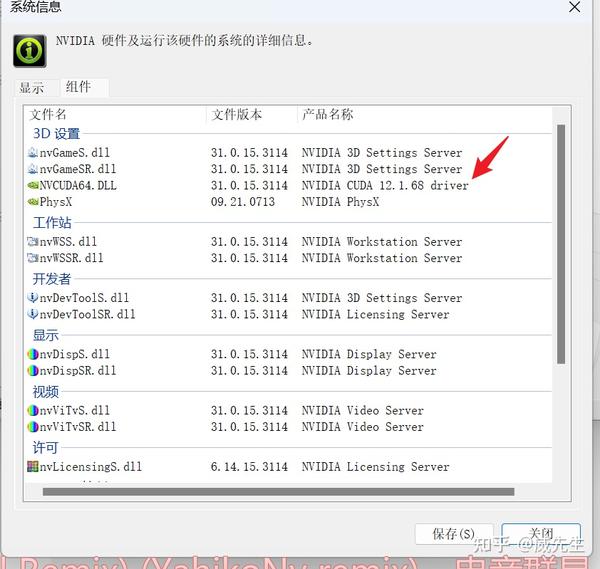

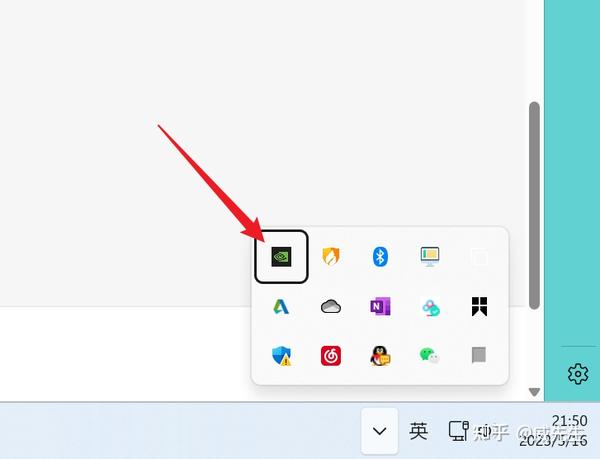

打开桌面右下角“英伟达设置”,查看驱动程序版本

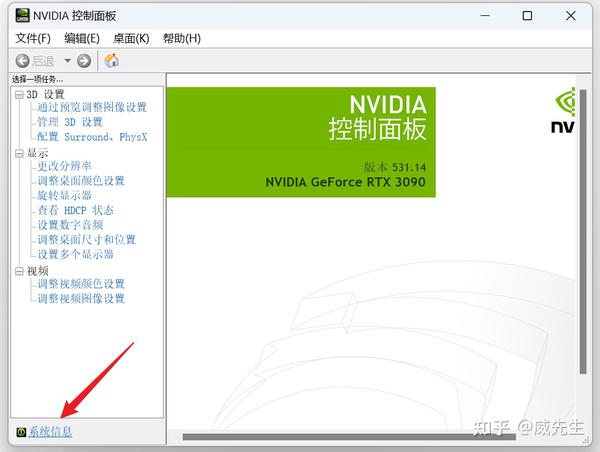

点击系统信息

查看驱动版本,进入 https://docs.nvidia.com/cuda/cuda-toolkit-release-notes/index.html 查看对应cuda

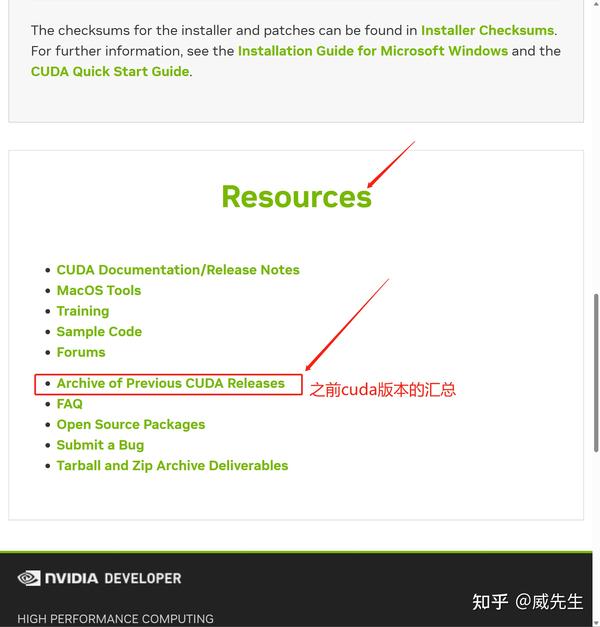

进入cuda官网 CUDA Toolkit 12.1 Update 1 Downloads | NVIDIA Developer ,找到 Archive of Previous CUDA Releases

点击需要的版本下载

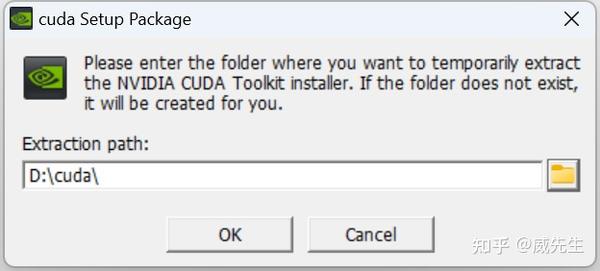

下载完成后点击安装

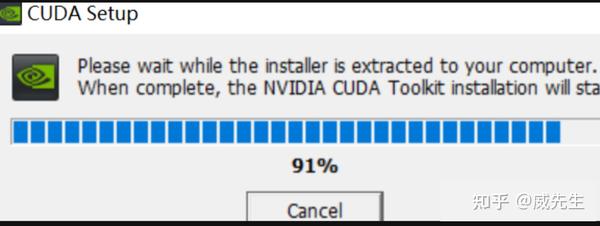

加载

加载完毕后选择精简版即可

最后尝cmd 输入以下 看一下是否安装成功,如果出现cuda版本就成功安装